Google Maps is duidelijk de meest populaire kaarten- en navigatie-app, niet alleen op Android maar ook op iOS. Het is de go-to-app voor het krijgen van routebeschrijvingen en het zoeken naar benzinepompen, restaurants of ziekenhuizen in de buurt. Een Twitter-gebruiker is echter op een denigrerende zoekopdracht gestuit die het zoekalgoritme van Google in twijfel trekt, vooral omdat het jonge kinderen kwetsbaar maakt.

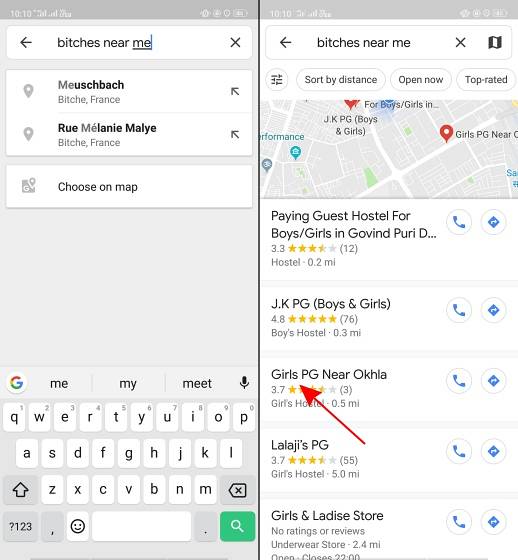

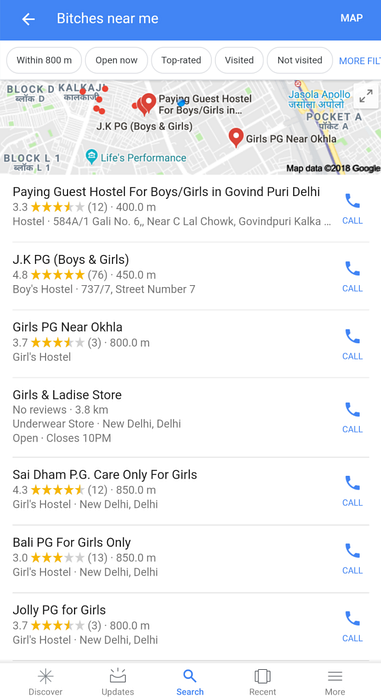

Zoals gemeld door Twitter-gebruiker @AHappyChipmunk, als je Google Maps opent en zoekt naar "bitches near me", en het zoekresultaat is gruwelijk. Het platform pikt dit denigrerende jargon op (dat we veroordelen) en toont meisjesscholen, hogescholen, hostels en betalende gastenappartementen, waardoor je even pauzeert. In een land als India waar het denigrerende N-woord door onwetende bevolkingsgroepen wordt gebruikt om te pronken, zijn zoektermen zoals teven niet moeilijk voor te stellen.

Google, kun je uitleggen waarom deze klootzak bestaat pic.twitter.com/w0eslFoVSz

- 🌻compañero avalakki ✨ (@Woolfingitdown) 25 november 2018

Deze tweet komt als een vreselijke verrassing, maar toen ik het logo van een trollen-Twitter-account (@trollenku) zag, stond ik sceptisch tegenover de bovenstaande tweet en ik dacht aanvankelijk dat het een grap was. Pas toen we zelf dezelfde zoekopdracht gebruikten, realiseerden we ons dat het niet alleen scholen zijn - het algoritme van Google retourneert elke plaats bij jou in de buurt die gerelateerd is aan meisjes - inclusief verhuur voor alleen meisjes en andere hostels.

Hetzelfde geldt voor Google-zoekopdrachten voor die zin:

Men moet begrijpen dat niemand in Google hiervoor verantwoordelijk is. Het algoritme van Google lijkt teven te correleren met meisjes, wat opnieuw de vooringenomenheid van AI in twijfel trekt. Een machine leert immers alleen wat u hem leert.

De zoekresultaat toont de donkere kant van AI en hoe popcultuur je kan conditioneren om bepaalde termen met een bepaald geslacht te associëren. Het laat ook zien hoe de mensen die deze zoekalgoritmen maken, denken. Google zou vooral op zijn hoede moeten zijn na de massale uitval van werknemers in verband met seksuele intimidatie op zijn kantoren eerder deze maand. De vermeende 'bro-cultuur' bij Google heeft het ook een paar rechtszaken opgeleverd. En deze nieuwste AI-blunder komt op een moment dat de zichtbaarheid wordt vergroot dankzij de # MeToo-beweging in India.

Veel mensen hebben naar Google getweet voor meer informatie over dit algoritme. We zullen u de update brengen zodra we een reactie van het bedrijf hebben ontvangen.

Gadgetshowto

Gadgetshowto