De 21e eeuw is getuige geweest van AI (kunstmatige intelligentie) die taken vervulde zoals het handig verslaan van mensen bij het schaken of hen snel vreemde talen leren.

Een meer geavanceerde taak voor de computer is het voorspellen van de kans dat een dader een ander misdrijf begaat. Dat is de taak van een AI-systeem genaamd COMPAS (Correctional Offender Management Profiling for Alternative Sanctions). Maar het blijkt dat die tool niet beter is dan een gemiddelde kerel, en ook racistisch kan zijn. Nou, dat is precies wat een onderzoeksteam heeft ontdekt na een uitgebreide bestudering van het AI-systeem dat veel wordt gebruikt door gerechtelijke instellingen.

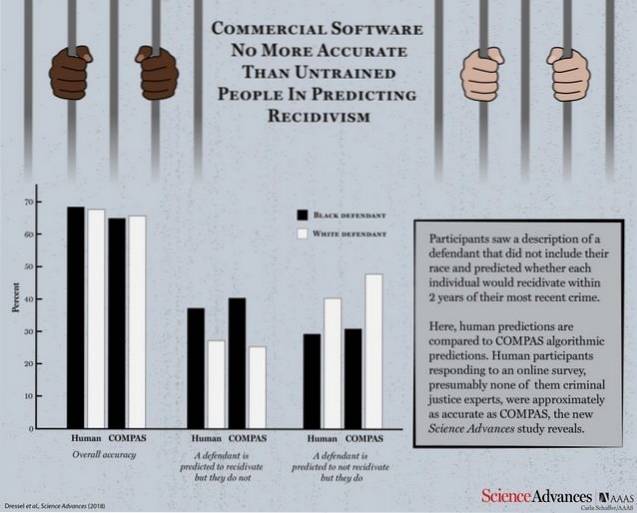

Volgens een onderzoekspaper gepubliceerd door Science Advances, werd COMPAS opgesteld tegen een groep menselijke deelnemers om de efficiëntie te testen en te controleren hoe goed het presteert tegen de logische voorspellingen van een normaal persoon. De machine en de menselijke deelnemers kregen 1000 testbeschrijvingen met leeftijd, eerdere misdaden, geslacht enz. Van overtreders waarvan de kans op herhaalde misdrijven moest worden voorspeld.

Met aanzienlijk minder informatie dan COMPAS (slechts 7 functies vergeleken met COMPAS 137), is een kleine groep niet-experts net zo nauwkeurig als COMPAS in het voorspellen van recidive.

COMPAS klokte een algehele nauwkeurigheid van 65,4% bij het voorspellen van recidive (de neiging van een veroordeelde crimineel om te recidiveren), wat minder is dan de collectieve voorspellingsnauwkeurigheid van menselijke deelnemers die op 67% staat.

Neem nu even de tijd en bedenk in gedachten dat het AI-systeem, dat het niet beter doet dan een gemiddeld persoon, door rechtbanken werd gebruikt om recidive te voorspellen.

Commerciële software die veel wordt gebruikt om recidive te voorspellen, is niet nauwkeuriger of eerlijker dan de voorspellingen van mensen met weinig tot geen strafrechtelijke expertise die reageerden op een online enquête.

Wat nog erger is, is het feit dat het systeem net zo gevoelig bleek voor raciale vooroordelen als zijn menselijke tegenhangers toen hen werd gevraagd de kans op recidive te voorspellen op basis van beschrijvingen die ook raciale informatie van de daders bevatten. Je zou daar niet al te verbaasd moeten zijn, want het is bekend dat AI de patronen aanneemt die zijn menselijke leraren het zullen programmeren om te leren.

Hoewel beide partijen drastisch tekort schieten in het behalen van een acceptabele nauwkeurigheidsscore, roept het punt van het gebruik van een AI-tool die niet beter is dan een gemiddeld mens veel vragen op.

Gadgetshowto

Gadgetshowto